本文最后更新于:2022-07-11T10:36:24+08:00

Hive 客户端与属性配置

CLIs客户端和命令

Hive中的命令行客户端主要分为两种,第一代客户端hive和第二代客户端beeline。

第一代客户端$HIVE_HOME/bin/hive,主要功能是交互式或批处理执行Hive查询,以及启动hive相关的服务,如Metastore服务和HiveServer2服务。

1 2 3 4 5 6 7 8 hive # 无参数表示直接进入交互式客户端

第二代客户端$HIVE_HOEM/bin/beeline,通过thrift连接到单独的HiveServer2服务上,再连接到Metastore服务。beeline支持的参数可以通过官方文档进行查询:HiveServer2

Clients - Apache Hive - Apache Software Foundation

Configuration

Properties属性配置

Hivev除了默认的属性配置之外,还支持用户使用时修改配置。修改配置的时候,我们应该关注有哪些属性支持修改,属性的功能和作用,支持何种方式进行修改,修改后的作用时间和作用范围。

Hive的配置属性再HiveConf.java类中进行管理,详细的配置参数可以参考:Configuration

Properties - Apache Hive - Apache Software Foundation

配置属性的方法一共有4种,分别如下:

方式1:hive-site.xml

在$HIVE_HOME/conf路径下可以添加hive-site.xml文件,可以定义配置属性。该配置文件会全局生效

方式2:--hiveconf命令行参数

hiveconf是一个命令行参数,在启动hive或者beeline命令行客户端的时候可以进行指定。该配置在整个会话session过程中有效,会话结束之后即失效

方式3:set命令

在会话中使用set命令进行配置,该配置对该会话中,set命令之后所有SQL语句生效

方式4:服务特定配置文件

服务特定配置文件主要包括hivemetastore-site.xml和hiveserver2-site.xml,分别表示对应服务特定的配置文件。

Hive

Metastore会加载可用的hive-site.xml以及hivemetastore-site.xml配置文件

HiveServer2会加载可用的hive-site.xml以及hiveserver2-site.xml

如果HiveServer2以嵌入式模式使用元存储,则还将加载hivemetastore-site.xml

总结来说:

配置优先级:set设置 > hiveconf参数 >

hive-site.xml配置文件

Hive也会读入Hadoop配置,Hive的配置会覆盖Hadoop的配置进行生效

Hive 内置运算符

整体上,Hive支持的运算符可以主要可以分为五个种类,关系运算、算术运算和逻辑运算,还有字符串运算符以及复杂类型操作符,官方参考文档地址为:Language

Manual UDF - Apache Hive - Apache Software Foundation

可以通过以下命令查看运算符的使用方式:

1 2 3 4 5 6 7 8 --显示所有的函数和运算符

下面对常见的运算符进行列举,基本都可以见名知义,只有一些特殊地方会注释说明

关系运算符:

1 2 3 4 5 6 7 8 9 10 11 12 13 = ==

算术运算符:

1 2 3 + - * / %

逻辑运算符:

1 2 3 4 and or not !

字符串运算符:

复杂类型运算符:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 --复杂类型构造

Hive 函数基础

Hive中内置了很多函数,用于满足用户的不同需求。我们可以通过show functions来查看当前可用的所有函数,通过describe function extended func_name来查看函数的使用方式

Hive中的函数分为两大类:内置函数(Built-in

Functions)和用户定义函数UDF(User-Defined Functions)

Hive 内置函数

内置函数根据应用整体可以分为:字符串函数、日期函数、数学函数、集合函数、条件函数、类型转换函数、数据脱敏函数、其他杂项函数。这里只分别介绍常用的函数

字符串函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 --字符串拼接

日期函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 --获取当前日期: current_date

数学函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 --取整函数: round 返回double类型的整数值部分 (四舍五入)

集合函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 --集合元素size函数: size(Map<K.V>) size(Array<T>)

条件函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 --if条件判断: if(boolean testCondition, T valueTrue, T valueFalseOrNull)

类型转换函数:主要用于显式的数据类型转换

1 2 3 4 --任意数据类型之间转换:cast

数据脱敏函数:主要完成数据脱敏,屏蔽原始数据

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 --mask

其他杂项函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 --如果你要调用的java方法所在的jar包不是hive自带的 可以通过使用add jar命令进行添加

Hive 自定义函数

用户定义函数则可以根据输入输出的行数来分为3类:UDF、UDAF、UDTF

UDF(User-Defined Function):普通函数,一进一出

UDAF(User-Defined Aggregation

Function):聚合函数,多进一出

UDTF(User-Defined Table-Generating

Function):表生成函数,一进多出

UDF分类标准扩大化:

UDF分类标准本来针对的是用户自己编写开发实现的函数,但是现在可以扩大到Hive的所有函数中,包括内置函数和用户自定义函数。因为内置函数也可以满足根据输入输出划分的要求

自定义UDF函数实现步骤:

自己写一个Java类,继承UDF,并重载evaluate方法 ,方法中实现函数的业务逻辑(注意重载)

将程序打包成jar包,上传到服务器环境中(本地或者HDFS)

在客户端命令行中添加jar包到Hive的classpath中:add jar /.../xxx.jar

注册称为临时函数,即给自定义函数命名:create temporary function 函数名 as 类的全路径

之后就可以在HQL中使用该函数了

在maven工程中应该引入下面的依赖:

1 2 3 4 5 6 7 8 9 10 <dependency > <groupId > org.apache.hive</groupId > <artifactId > hive-exec</artifactId > <version > 3.1.2</version > </dependency > <dependency > <groupId > org.apache.hadoop</groupId > <artifactId > hadoop-common</artifactId > <version > 3.1.3</version > </dependency >

1 2 3 4 5 6 7 8 import org.apache.hadoop.hive.ql.exec.UDF;public class MyUDF extends UDF {public String evaluate (...) {

自定义其他函数如UDTF,规则不尽相同。

Hive 函数高级用法

explode函数和侧视图

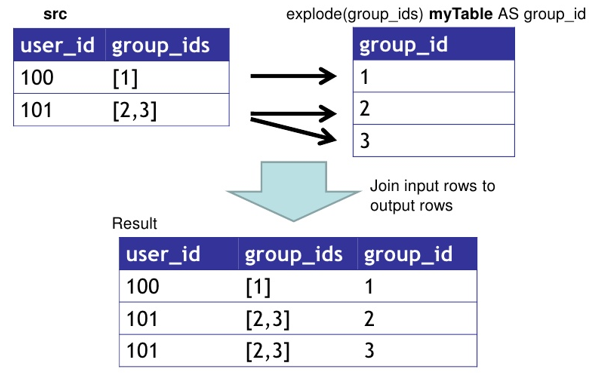

explode函数可以接受map、array类型的数据作为输入,然后把输入数据中的每个元素拆开成为一行数据。array类型则一行对应一列,map类型则一行对应两列(Key-Value)

explode函数是一个UDTF函数,它的执行结果可以理解成为一张虚拟的表,数据来源于源表。我们可以在select中查询源表数据,也可以只查询explode生成的虚拟表数据,但是不能直接查询源表和虚拟表的数据。(不能不做任何处理就查询分别属于两张表的字段)

explode函数将复杂类型展开之后,展开的每一行和源表的行会有一个对应关系,即源表中一行对应到展开表中的多行,根据这种关系我们可以使用join连接两张表,不过在Hive中给我们提供了侧视图lateral

view语法来实现这种效果。explode函数一般会结合侧视图lateral

view一起使用

语法如下:

1 2 3 4 5 --单独使用explode函数

这里的UDTF可以使用explode函数,当然侧视图的效果可以配合其他的表生成函数一起使用,不仅仅局限于explode函数。

别名1表示源表的别名

别名2表示UDTF函数生成的表别名

as col1 col2 col3...表示给生成表中的列取名侧视图的底层相当于就是自带条件的inner join

聚合函数

聚合函数的功能是对一组值执行计算并返回单一的值,是典型的UDAF函数,多进一出。通常搭配group

by语法一起使用,在分组之后进行聚合操作

常见的聚合函数有:

count:统计检索到的总行数sum:求和avg:求平均min:最小值max:最大值collect_set(col):数据收集函数,去重collect_list(col):数据收集函数,不qu'chong

同时Hive来提供增强聚合的方式,包括grouping

sets、cube、rollup等函数。增强聚合多用于多维数据分析,它达到的效果是可以综合多个分组后的结果,然后利用字段grouping__id来表示该行是通过哪个分组group得到的。

如果利用已有的方式来达到这样的操作,应该使用union连接多个经过group

by的表,并且需要手动填充null列来保证列数的对应,而使用增强聚合就可以方便地达到这样的效果

注意grouping__id是双下划线

grouping sets :

可以将多个group by逻辑写在一个sql语句中,等价于将不同维度group

by结果集进行union all,grouping__id表示结果数据哪一个分组集合

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 select

cube :

cube表示根据group by维度的所有组合进行聚合

例如group by有a b

c三个维度,则cube取所有的子集,共8个,注意包括空集,即表示不进行group

by

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 select

rollup :

rollup是cube的子集,以最左侧的维度为主。只有当左侧维度出现,右侧维度才可能出现。相当于是一个递进的关系

例如group by有a b c三个维度,则rollup取的组合情况有()、(a)、(a,

b)、(a, b, c)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 select

窗口函数

基本语法

Hive中的窗口函数也和MySQL中的类似,语法如下:

1 Function(arg1, ...) over ([partition by <...>] [order by <...>][<window_expression>])

Function表示需要应用的函数,可以是聚合函数(例如sum、max、avg等),可以是排序函数(例如rank、row_number等),可以是分析函数(例如lead、lag、first_value等)

partition by:分组依据。

order by:分组内部的排序规则

window_expression:用于指定窗口的范围

over中的参数是可选的,但是出现与否的效果有所差异:

没有partition by,则将整张表看作一个分组

没有order by没有窗口范围,则计算分组中的所有行

有order by没有窗口范围,则计算分组中从开始到当前行的范围

窗口表达式

窗口表达式提供给我们一种控制行范围的能力,语法如下:

1 2 3 4 5 6 --关键字是rows between,可选项有

举例如下:

1 2 3 4 5 6 7 8 9 10 11 --向前3行到当前行,共4行

窗口排序函数

主要用于给每个分组内的数据打上排序的标号,主要用于TopN的业务分析,注意窗口排序函数不支持窗口表达式

row_number():递增,不考虑重复,序号连续rank():考虑重复,但是会挤占后续位置,序号可能不连续dense_rank():考虑重复,但是不挤占后续位置,序号连续

窗口排序函数中还有一个ntile(),用于将每个分组内的数据分到指定的若干个桶内,即分为若干个部分,并且为每个桶分配一个桶编号。划分的依据主要是按照顺序平均分配,如果不能平均分配,则优先分配到较小编号的桶中,并且各个桶之间的行数相差最多为1。(对应需求可能是将数据排序后分成几个部分,业务人员只关心其中的一部分)

窗口分析函数

lag(col, n, default):返回当前行往上的第n行的对应值,相当于一个数据偏移的操作

第一个参数为列名

第二个参数为n,表示偏移多少行

第三个参数为默认值,表示如果往上第n行为null的时候,取默认值default。如果不指定,则为null

lead(col, n, default):返回当前行往下的第n行的对应值first_value():取分组内排序后的第一个值last_value():取分组内排序后的最后一个值

其中first_value()和last_value()取的是分组范围内的第一个和最后一个,因此窗口范围很重要,要终点关注窗口范围。

抽样函数

抽样是一种用于识别和分析数据中子集的技术,用以发现整个数据集中的模式和趋势。在HQL中,可以通过三种方式来进行数据采样:随机采样,存储桶表采样和块采样

Random随机采样:

使用rand()函数确保随机获得数据,使用limit限制抽取的数据个数

优点是随机,缺点是速度慢

推荐使用distribute+sort,底层执行效率更高

1 2 3 4 5 6 7 --需求:随机抽取2个学生的情况进行查看

Block基于块随机抽样:

块采样允许随机获取n行数据、百分比数据或者指定大小的数据

采样粒度是HDFS文件块大小

优点是速度快,缺点是不随机

1 2 3 4 5 6 7 8 select * from student tablesample(1 rows);

Bucket table基于分桶表抽样:

一种特殊的采样方法,针对分桶表进行优化

既随机,速度也较快

语法如下:

1 tablesample (bucket x out of y [on colname])

y必须是table总bucket数的倍数或者因子。hive根据y的大小,决定抽样的比例

例如,table总共分了4份(4个bucket),当y=2时,抽取(4/2=)2个bucket的数据,当y=8时,抽取(4/8=)1/2个bucket的数据。

x表示从哪个bucket开始抽取

例如,table总bucket数为4,tablesample(bucket 4 out of 4)表示总共抽取(4/4=)1个bucket的数据,抽取第4个bucket的数据

注意:x的值必须小于等于y的值,否则会报错failed:numerator should not be bigger than denominator in sample clause for table xxx

on colname表示基于什么抽

on rand()表示随机抽

on 分桶字段 表示基于分桶字段抽样 效率更高 推荐